선형회귀모형과 로지스틱 회귀모형은 용도가 다르다.

선형회귀모형은 예측을 위한 회귀모형이고, 로지스틱 회귀모형은 분류를 위한 회귀모형이다.

1. 선형회귀모형의 정의

총 n개의 객체중에 i번째 객체에 대한 연속형 목표변수 값을 $Y_i$라고 한다.

입력변수들의 값을 X1i, X2i, ..., Xpi라고 할 때 선형회귀모형은 아래와 같이 정의할 수 있다.

- 상수 $\beta$

회귀모수(regression parameters) 또는 회귀계수(regression coefficients)라고 한다.

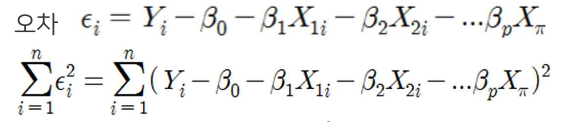

- 오차

$\epsilon_i$는 $Y_i$의 근사에서 오차항이라고 한다.

- 가정

각 객체들의 오차는 서로 독립(independent)이고 평균이 0인 일정한 분산(constant variance)을 가진 정규분포(normal distribution)를 따른다고 가정한다.

2. 회귀모수의 추정

오차 제곱합을 최소화 하는 모수를 찾는 과정이다.

입력변수 X와 목표변수 Y의 산점도를 보면 직선의 기울기를 찾는 것이 중요하다.

각 관측치로부터 회귀직선까지의 수직 거리 제곱의 합을 최소화 하는 회귀모수를 찾는 최소제곱추정법(LSE: least square estimation)를 주로 이용한다.

오차를 최소화 하는 추정값을 각각 $\hat {\beta_j}$라고 할 때, 이를 이용한 최소제곱 회귀직선(least square regression line)은 아래와 같다.

3. 회귀계수의 해석

회귀계수 $\beta_j$는 다른 입력변수들이 일정할 때 j번째 입력변수 $X_j$가 한 단위 변동할 때 대응하는 Y의 변동 양으로 해석한다.

$\beta_j$는 다른 입력변수를 보정한 후에 Y에 대한 X의 기여도를 말한다.

회귀계수 $\beta_j$가 양수(positive)라면 $X_j$가 증가할 때 Y도 증가하고

반대로 $\beta_j$가 음수(negative)라면 $X_j$가 증가할 때 Y는 감소한다.

4. 입력변수의 중요도

$\beta_j$는 다른 입력변수 조건들이 모두 동일할 때 특정 입력변수와 출력변수(or 목표변수)사이의 관계를 나타내는 것에 대한 영향력을 얘기한다. 탄성치라고 하기도 한다.

선형회귀모형에서 변수의 중요도는 t-value로 측정한다.

j번째 입력변수 $X_j$에 대한 t값은 아래와 같이 정의한다.

단 standard error인 $SE(\hat {\beta_i})$ j번째 회귀계수의 추정치 $\hat {\beta_i}$의 표준오차 t-value가 절대값이 클수록 영향력이 크다고 판단한다.

5. 모형의 적합도

1) F-값

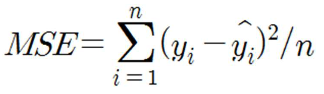

F값은 회귀직선에 의해 평균적으로 설명할 수 있는 부분(MSR:mean squared regression) 에서 설명할 수 없는 부분(MSE:mean squared error)을 나눠준 것이다.

F값이 크면 p개의 입력변수 중에 최소한 하나는 유의하다. (대립가설)

F-값이 작아서 P-값이 크면(보통 0.05보다 크면), 모든 입력변수가 유의하지 않다. (회귀계수가 0이다)

- SSR : 회귀직선으로 설명할 수 있는 부분의 총합

- SSE : 설명할 수 없는 부분의 총합(오차제곱합)

2) 결정계수 $R^2$

모형의 적합도(goodness-of-fit)를 결정계수(coefficient of determination) $R^2$측정한다.

결정계수 ($R^2$) : 설명할 수 있는 부분의 총합을 변동의 총합으로 나눈 값으로 0과 1 사이의 값. 총변동 중에 회귀직선으로 설명할 수 있는 변동 부분이다.

얼마나 퍼져있는지에 대해 설명한다. 단순히 많이 퍼져있는 것보다 추세를 가지고 직선의 모양을 가지는 것이 패턴을 설명하기 쉽다.

- SST(sum of squared total variation) : 총변동합

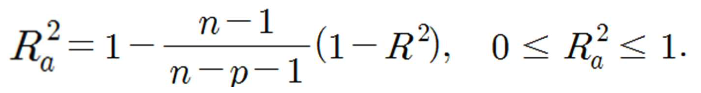

3) 수정된 결정계수

입력변수가 늘어나면 결정계수는 증가한다. 그러나 변수가 많으면 과다적합될 가능성이 높기 때문에 결정계수를 보정해줘야 한다.

수정된 결정계수 (adjusted $R^2$) : 자유도를 고려한 결정계수

관측치와 입력변수의 갯수를 함께 고려하기 때문에 입력변수가 높아질 때 결정계수가 제곱 때문에 과도하게 높아지지 않도록 보정한다.

4) AIC(Akaike Information Criterion)

입력변수의 수가 다른 모형들을 비교 평가하는 기준으로 여러 후보 모형들 중에서 가장 작은 AIC를 가지는 모형이 오차가 적은 것으로 판단되어 선택한다.

입력변수의 수가 증가할 수록 SSE는 감소하지만 패널티 2p를 더한 값을 의미한다.

6. 모형을 이용한 예측

주어진 데이터에 기반하여 회귀식 Ŷ을 얻었을 때 임의의 객체 i*에 대해 관측한 입력변수의 값 x1i*, x2i*, …, xpi*를 그 회귀식에 대입하여 목표변수의 예측치 $\hat Y_{i^*}$ 를 얻을 수 있다.

7. 예측력

목표변수가 연속형인 경우에 모형의 예측력 측도로서 MSE(mean squared error)를 주로 사용한다.

- 평균절대오차를 사용하기도 한다.

- 시각적으로 관측값 $y_i$ 와 예측값 $\hat Y_{i^*}$ 의 차이를 확인하기 위해서는 이들을 가로축 및 세로축에 놓고 그린 산점도가 45도 대각선을 중심으로 모여 있으면 예측력이 좋다고 평가한다.

'Data Science > Data Mining' 카테고리의 다른 글

| [DataMining] 로지스틱회귀모형 (1) | 2022.04.05 |

|---|---|

| [DataMining] 데이터마이닝이란? (1) | 2022.04.03 |

댓글